档案

如何在EViews或Stata里计算Finsher转化值?

旭 @ 2009-07-23:

祝老师您好!我是一个学经济学的学生,目前正在做毕业论文,是关于跨国GDP与消费之间相互关系的研究。看了您的“如何检验两个相关系数的差别?”一文,感觉受益匪浅,帮助很大。因为这就是我要做的东西:把各国之间GDP与消费增长率的相关系数算出来,然后把对应的GDP与消费增长率的相关系数(如中美之间GDP增长率的相关系数和中美之间消费增长率的相关系数)做费雪转化,求出Z值看他们之间的区别显不显著。在文章里您给出来算费雪Z值的一个EXCEL公式,可以算出结果。但是我的导师说EXCEL不是一个ACCEPTABLE统计软件,让我用EVIEWS或者STATA软件做这个结果,想请教下您,能不能在这两个软件里做上述分析结果呢?如果可以,该怎么做呢?

庄主 @ 2009-08-30:

任何软件只要其公式一样,结果应该是一样的,不存在高贵低贱之分。我曾说过,SPSS是傻瓜机而Excel是智能机,因为前者一般只报告计算结果而不显示计算步骤,而Excel是让你自己一步一步算出结果。就这意义上说,其它统计软件(包括EViews、Stata、SAS等)也是傻瓜机。当然,就本案的如何计算Fisher z-transformation而言,我在原文中教大家的是直接套用Excel提供的函数FISHER(),那也是一个傻瓜工具。但你也可以根据我原文中的公式2

写出如下的Excel计算公式:=0.5*LN((1+A2)/(1-A2))

注,其中“A2”是你的相关系所在格。你也可以先用函数求、再用手工来验证。难道这样的结果还不acceptable?

如果一定要用高贵的EViews、Stata或其它软件来计算,道理一样。首先,你要建一个新文件,将你的相关系数作为一个变量放到一个column里,然后写一句类似上述Excel公式的指令,如

F = 0.5*LN((1+R)/(1-R))

其中F是转换后的值,R是原始相关系数。我手头没有EViews和Stata的手册,不知它们是有LN还是其它符号来代表自然对数函数。

再次呼吁:同学们大家起来,不要做统计软件的奴隶!

如何解读一个交互影响显著而简单斜率不显著的回归模型?

Anonymous @ 2009-07-30:

Hi, Dr ZHU, I may want introduce myself first, I am a Phd Candidate from your university majoring in xxx (EDITED BY 庄主). I find your forum by accident and I have read some reviews on it, I really feel it is a good place to know more statistics knowledge.

I want to ask one question about the interaction effects of two independent variables (or we may also can say the moderating effect of one independent variable and one moderator, I may name them "A" and "B") on one dependent variable (I may name it "C"). I first use the traditional method, OLS- multiple linear regression in SPSS to run the produced term A*B’s effect on C, I got a significant result, the T value is around 2.2 thus the P<0.05.

Then I further explore the internal mechanism of the interaction effect by using Cohen and Cohen (1983), Aiken and West (1991) and Dawson and Richter’s (2006) Simple Slopes Test [this method is designed for interpretation of the interaction effects of two continuous predictor variables, by this way one could interpret the significance level of the causal relationships between independent variable and dependent variable under high or low level of the moderator. To illustrate and test the significant interaction effects, separate regression lines were computed, plotted, and tested with one standard deviation below the mean on the moderating variables as well as one standard deviation above the mean of them.], this time I find the causal relationship between A and C is insignificant both under high B and low B level, in fact the coefficients take the opposite direction. Under high B level the coefficient between A and C is negative but insignificant, under low B level the coefficient between A and C is positive but insignificant.

I originally explain the significant moderating effect is: although under both high and low B level the causal relationship between A and C is insignificant, but because of the opposite coefficient, thus the moderating effect (A*B) may still be significant. But current one famous professor rejected my explanation; he told me that the results were inconsistent: 1. from one side, the moderating effect is insignificant. 2. form the other side, both under high and low B level, the causal relationship between A and C is insignificant thus can be treated as no relationship. How can you say them taking moderating effect first and later told us the effects were equal (A and C have no relationship) under both conditions (high and low B level)? Thus I am a little confused, as you know, in many cases, run the linear regression will meet such question as I described, so commonly how can we explain this phenomenon to cope with the journal reviewers’ critique on this issue?

Many thanks!

庄主 @ 2009-08-29:

Thanks for the detailed explanations of your question. It’s satisfying to know that someone of my own institution also reads this blog. Sorry for the delayed response as I’ve been traveling in the summer. To benefit other readers who might not be efficient in English, please allow me to reply in Chinese.

先简单回顾一下你的问题。你有模型1

C = b0 + b1A + b2B + b3AB (1)

其中A、B和C都是定距变量。你用OLS回归检验,发现b3(还是b1或b2?)的t值 = 2.2 (p < 0.05),即AB对C有显著的交互影响。为了进一步理解这种交互关系的“内在机制”,你采用了Cohen & Cohen等推荐的“简单斜率检验法”(test of simple regression slope),即根据模型1的结果,将B的均值±1个标准差的值(分别记为BH和BL)代人模型1,来算出以下两个简单回归模型的斜率:

C = b0 + b1A + b2BL+ b3ABL = (b0 + b2BL) + (b1+ b3BL)A (2)

和

C = b0 + b1A + b2BH+ b3ABH = (b0 + b2BH) + (b1+ b3BH)A (3)

说明:因为BH和BL均是一个常数(而原来的B是一个变量),所以它们代入模型1后而得到的模型2和3,经过整理以后,都成为只含自变量A的一元(或简单)回归模型,而模型2中的b1+ b3BL和模型3中的b1+ b3BH就是你说的的简单斜率(就是我用蓝色标明的部分)。这时,你发现模型2的简单斜率b1+ b3BL成了负值而模型3的简单斜率b1+ b3BH仍是正值。你进一步对这两个斜率作了显著检验,发现两者均不显著。你的结论是“虽然A在调节变量B的不同条件下对C都没有显著影响,但是A和B的显著交互影响仍然存在”。但是,一位著名教授不同意你的说法,理由是:一、你的交互影响不显著(我不理解这句话,因为它与你说的模型1中的t = 2.2有矛盾);二、A在B的不同条件下对C的影响都不显著。(不知我的上述理解是否有误?)

好了,现在谈谈我的看法。

首先,我有两处不清楚:一、如我已在上面问过,模型1中显著的是b3还是其它系数?二、你还没有提到,模型1中的A、B和AB是否为各自的centered values(“取中值”,以避免或降低AB与A、AB与C之间的相关程度)?鉴于你已读过Cohen & Cohen, Aiken & West等经典文献,应该熟悉检验交互影响的基本步骤,所以我的回答是基于以下假定的:一、你说的模型1中t = 2.2的显著系数是b3;二、模型1中AB与A、AB与C之间并不相关(这点很重要,不然、假定一是没有意义的)。

如果上述两个条件成立,那么你的A和B在样本中对C就是确实具有显著的交互影响。当然,因为你的t值接近临界值(1.96或更大),AB的交互影响应该是marginal(相当勉强)的,所以要审慎对待,至少要检查一下A的数据中是否存在异常值;如有异常值,则需要剔除后再次检验模型1,看看AB的影响是否继续保持显著,已确保该模型的robustness(“鲁棒性”)。

你的主要困惑(也是你教授理由之二)在于:为什么在模型1的b3显著的前提之下,模型2和3的斜率不显著?这里存在一个许多教科书上没有明确解释、但初学者往往容易误解的事实,即AB之间的显著交互关系只是说明自变量(A)对因变量(C)的主影响(main effects)将随着调节变量(B)的取值而变化,但并不保证在B的不同取值上A的所有主影响都是显著的(但至少有一个取值上A的主影响是显著的,否则AB不可能显著)。用英语说,A significant interaction effect ensures not only the main effect of an independent variable on a dependent variable varies across different levels of a moderator variable, but also at least one of the main effects is significantly different from zero. However, the significant interaction doesn’t guarantee all main effects of the independent variable on the dependent variable to differ significantly from zero. 我们很容易用以下的图示来说明这个道理。

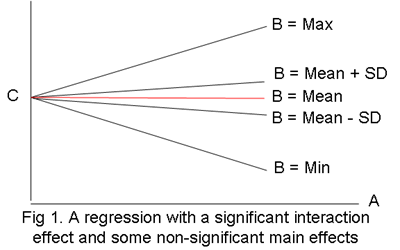

左图是我随手画的,其中有五条回归线,但都是根据同一模型(如你的模型1)而取B的最大值(Max)、最小值(Min)、均值(Mean)、均值减一个标准差(你的模型2)、均值加一个标准差(你的模型3)而画出的。虽然没有实际数据,但可以大致猜出五条回归线所依据的模型1的b1和b3的取值范围,即b1(即A的总斜率)应该等于0,b3(即AB的交互影响)则明显大于0(因为A对C的影响是放射的、即随着B的增加而增加)。当然,我们并不知道(也无必要知道)b0和b2的取值范围,因为它们与本案毫无关系。

图中B=均值的回归线显然是一条水平线,所以是不显著的(即斜率等于0)。而B=均值加/减标准差的两条线,虽然并非水平线,但也很接近,考虑到各自的抽样误差(注意,不要与标准差相混淆了)而其斜率与0没有显著差别(也许你的数据就是这种情况)。但是,B=极大值/极小值的两条线的斜率显然不等于0。如果我们再添加B=均值+/-2个标准差的两条线,可以想象它们的斜率也会不等于0。结论:当A和B对C有显著影响时,A对C的影响随着在B的取值而变化,有些显著而有些可能不显著。

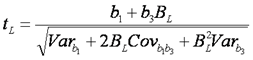

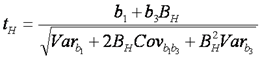

以上是直观的解释。我们还需要略正规一点地总结一下。回到模型2和3,注意其中的蓝色部分(即各自的斜率)。它们是否=0,是由下述公式来检验的:

和

其中Varb1和Varb2分别是b1和2的方差、Covb1b3是b1和2的协方差。我们略过如何计算系数的方差和协方差的技术细节,而来看一下如何使得tL和tH达到显著水平(即大于2)。不言而喻的是分子要大而分母要小。就分子而言,从表面上看b1、b3和BH或BL三者均要越大越好,但更重要的是要三者取同样方向,否则会互相抵消(这不容易做到,尤其是当数据经过中心化处理之后,BL一定是负的,而b1或b3的方向也会因A或B的中心化而与原始数据的方向相反)。而且,调节变量的取值(BL或BH)也不是越大越好,因为同时也会扩大分母。结论:tL和tH的取值受到很多正反因素的影响,很难做到永远显著。但是,这与b1是否显著没有一一对应关系。

最后,你问如何使得期刊的reviewers接受你的解释。是的,有些(如果我用“很多”的话,大家可能会觉得我太狂妄,但是事实上“有些”不是一个小数目)reviewers也会将交互影响等同于主影响,所以你不仅要自己弄得很清楚,而且要说得很明白易懂,这时,公式和图表就是必要的辅助工具了。如何写好交互影响的报告,确是一个挑战。多读几遍Cohen & Cohen吧(他们的第三版就邀Aiken和West加盟合写了)。

给SSCI期刊投稿应该先投后改还是先改后投?

>

P @ 2009-08-20:

您怎么看下面两位SCI/SSCI期刊审稿人的对话?有人也建议过我先送出去审,拿到意见再修改。

甲:投稿又撤稿,特别是给出修改建议之后再撤稿,有点不厚道。我遇到很多次,写的审稿意见不比文章短,从字词到如何布局,那些内容如何做,都写到审稿意见里。善意地给了revise & resubmit的意见。实际上,按照标准,reject一句话就是了。可是,过几个月后发现发表在另外一个杂志上。这种做法可以理解,但是不厚道,至少应该想办法感谢审稿人。

乙:我审稿也通常善意地给revise & resubmit的意见,很累,有些投稿者把审稿人当成论文加工把关人,不厚道。于是也慢慢的拒绝审一些稿件,或者直接reject。

庄主 @ 2009-08-22:

我看了之后的第一个感觉就是我们有些同胞真聪明,知道如何玩这个游戏!但是事实上,将草草急就章的文章投出去,往往拿不到什么真正有价值的反馈。上面乙某说的就是一例。我亦是如此。刚开始做审稿人时,不分良莠,每篇文章都写较详尽的修改意见。记得最多一次密密麻麻用单行写了5页,应该有3000字吧(但跟别人相比,还不算很长,下面引述的研究中最长的意见有6000多字呢)。但后来慢慢地就变得区别对待了,仍然愿意给“好”文章(不仅理论和方法好,而且写得通顺)提建设性意见、而对“差”文章(或者理论/方法差,或者写作差、包括完全不顾APA style规则的,),则草草几句“锯”了。

前不久读了Russell Neuman等人在JOC上发表的“传播研究中的七宗罪”一文,得知上述乙某和我的做法确实是大部分审稿人的习惯。Newman等分析了JOC的审稿人给100余篇投稿(包括采纳和拒绝的)写的具体意见,其中表四(见左)的数据展现的是审稿人对每篇来稿定的“罪名”数目。粗粗一看,被拒绝的稿件(白条)的罪名数少于被发表的稿件(黑条),如被发表的文章每篇平均有16条“表述不清”的罪名而被拒绝的文章每篇则有7条此类罪名。但是,这并不说明被拒的文章写得更好。恰恰相反,那些文字是too bad to be rescued(朽木不可雕),审稿人懒得多费心思。

Neuman等还做了一个多元回归分析,发现审稿人给每篇投稿写的意见长短是预测该文是否被采纳的重要指标之一。具体而言,意见每多1000字,有关文章的发表率就提高9%!所以,当你收到投稿的反馈时,如果是数十的批评,应该暗暗庆幸,该文很有希望。

以下是Neuman等的原文(下划线是我加的):

“We find a dramatically larger number of negative comments on average for accepted papers, especially on the dimensions of clarity, methodology, and completeness. On closer examination, it turns out to make sense in terms of the psychology of the hard-working volunteers called upon to provide the reviews. If the overall importance and theoretical integration of a submission is weak, the reviewers simply do not bother to spend a lot of time with constructive but negative comments on such things as clarifying an argument and strengthening the methodological presentation. On papers likely to be published, reviewers may go to greater length to indicate how the authors might be more complete and clear in their presentation.” (p. 229)

“This appears to be the academic journal review equivalent to the hoped-for thick envelope from a favored college to which one has applied—the more the reviewers say, positive and negative, the more interest in the submitted paper. So we examined the cross-tabulation of the total number of reviewer words and the likelihood of publication and ran a rudimentary linear least squares and determined that roughly for every additional 1,000 words of reviewer comments (including all dimensions), one’s chance of acceptance increases approximately 9%.” (p. 229).

Reference

Neuman, W. R., Davidson, W., Joo, S. H., Park, Y. J., & Williams, A. E. (2008). The seven deadly sins of communication research. Journal of Communication, 58, 220–237.

如何解读这个调查报告?

>

ANY @ 2009-08-19:

今年XX单位做了一个YY方面的调查,报告出炉后争议很大。我呢,虽没参与争议之中,因专业之故,很是关注。就我个人意见,我非常不理研究者组使用RDD法抽取了647人来代表全体北京人口,给各媒体排名。我极其质疑它使用的抽样技术。我认为非概率抽样中的配额抽样可能更适合做这个调查。

庄主 @ 2009-08-20 答: 我没看到那个报告。请进一步说明清楚,你质疑的是样本量太小、还是RDD(随机电话号码抽样)原则、或者其它问题?

你建议用配额抽样,我可以肯定地说配额抽样一定不适合。

ANY问:

我首先质疑的是调查组的抽样方法。我和研究者联系,希望得到更多细节,比如是随机拨号法,还是集群拨号法,但无法得到。 刚巧收到了回复,说:“抽样方法采用的是RDD,先通过不等概抽样(pps)确定前面四位局号,后面四位是随机选号(北京电话号码是8位),抽样是座机。”在此之前的争议中,有人怀疑的是647个样本来代表2000多万北京人的代表性。

庄主答:

你的怀疑和批判精神值得提倡。当然,如果对抽样基本原理有比较清楚的理解,则可以避免在怀疑和批判时犯常识性错误。

第一、样本大小涉及的是调查结果的精确度问题、而与代表性无关。样本越大、结果越精确,反之亦然。精确度有公式可以计算,即抽样误差。当N = 647而可信度 = 95%时,抽样误差 = ±3.8%。这个精确度是否足够?答案取决于具体的研究问题。如果被排序的两个媒体之间相差8%或更大,那么它们的高低是可靠的;反之则不然。

第二、抽样误差与总体大小无关。所以无论北京人口是2千万还是2亿,样本为647的抽样误差大小是不变的。

第三、样本的代表性取决于抽样是否随机、而与样本大小无关。如果一个非随机样本N=10000,虽然其抽样误差 < ±1.0%,但仍然没有代表性。一个没有代表性的大样本比一个精确度低的小样本更无价值。

ANY问:如果是抽取座机号码的话,我现在也高度怀疑样本的代表性。因为有很多在北京的人,终其一生不用座机。据经验推测的话,许多有北京户口的人也不见得使用座机。而上一次人口普查是把大量北漂计入了北京人口的。把大量无座机电话的人排除在总体之外,这意味着什么呢?而这是为什么我觉得配额抽样更好的缘故。

庄主答:

同意。如果上述调查的RDD是严格执行的话,那么其代表的是北京有座机的家庭人口。也就是说,该调查的Study Population(研究总体)是北京有座机的家庭人口、而不是北京所有家庭人口。研究者在报告时应该说明这一点。当然,研究总体限于“北京有座机的家庭人口”的一个调查是否有价值,即取决于其与北京所有家庭人口之比(你知道到底有多少人被排除之外的吗?)、也取决于研究目的。如果有关媒体(或广告商)更关心有座机家庭人口,那么也是无可非议的。商业调查毕竟不是民意测量。

配额抽样不是随机抽样,调查结果毫无价值。现在考考你:为什么配额不是随机抽样?

ANY问:

研究者用盖洛普1932年用1000个样本代表美国人预测了总统选举来证明其647人样本有代表性。我觉得这是个外行的支持。

庄主答:

你觉得我上面的回答是否已经解决了这个问题?如无,我再啰嗦几句。

ANY问:

问卷是看不到的。我个人看法,即使是RDD法,考虑分众化和个人媒介使用的多样性,问卷设计应当是一套很复杂的问卷。

庄主答:

抽样、问卷设计和调查(即问答过程)代表了每项调查的三个主要误差来源:抽样误差、工具误差和测量误差。每一项都要小心处理,并应在报告(或技术附件中)详细透露。如抽样方法、问卷原文、调查过程(尤其是最后一步的个人是如何被抽取的),以便读者对其研究结果的质量作出自己的判断。

ANY问:

我的问题纯出于专业上的兴趣。我非常想弄清楚这个问题。再次感谢您!

庄主答:

我是出于同样的原因而回答你的问题。

如何在SPSS里删除重复ID的个案?

>

L @ 2009-08-01:

如果在SPSS数据库里有一个变量是对case的编号,现在有可能某些case 是重复出现的,我想要将重复出现的case只保留一个,其余重复则删除掉,怎么完成这个任务?(除了手动的以外。)

庄主 @ 2009-08-02:

SPSS13版或之后的Data菜单下有一个“Identifying Duplicate Cases”的程序,应该可以解决你的问题。但我没有用过那个程序,而是用下述的syntax写一个程序来做,自己写的程序放心一点,不会错杀无辜的个案。(注:以下syntax其中的“ROW”和“ROW2”是两个临时变量,事后可以删去。如果你case的编号变量名不叫“ID”,请修改ID。)

sort cases by ID.

compute ROW=$casenum.

aggregate outfile ‘c:\temp.sav’/break ID/ROW2=first(ROW).

match files file */table ‘c:\temp.sav’/by ID.

select if ROW=ROW2.

delete variable ROW ROW2.

exe.

强烈建议你运行前,请先用下述模拟数据试一下,以检验上述程序是否对(即没有放过任何需要删的个案、也没有错删任何需要保留的个案)。

input program.

loop #i=1 to 10.

loop #j=1 to 3.

compute ID=#i.

end case.

end loop.

end loop.

end file.

end input program.

sort cases by ID.

compute ROW=$casenum.

aggregate outfile ‘c:\temp.sav’/break ID/ROW2=first(ROW).

match files file */table ‘c:\temp.sav’/by ID.

select if ROW=ROW2.

delete variable ROW ROW2.

exe.

| 数据a | 数据b | 数据c | 数据d |

|

|

|

|

上述syntax的第1-11句生成一个含有两个变量(ID和ROW)、30个个案(其中仅10个独立个案,但每个个案重复3次)的数据(见下图数据a)。第12句将数据a中每三个重复个案中的第一条记录的ID和行序号ROW抽出来保存到临时文件temp.sav中(见数据b)。第13句将数据a和数据b合并成数据c。第14句将数据c中的ROW(即数据a中的行序号)与ROW2(即数据b中的每个个案第一行的行序号)相等者选出;也就是说,将ROW和ROW2不相等者(即每个个案的重复行)删除。最后,第15句将临时变量ROW和ROW2删除,结果就是你想要的数据d。